Transistortechnologien

Bipolar-Transistoren

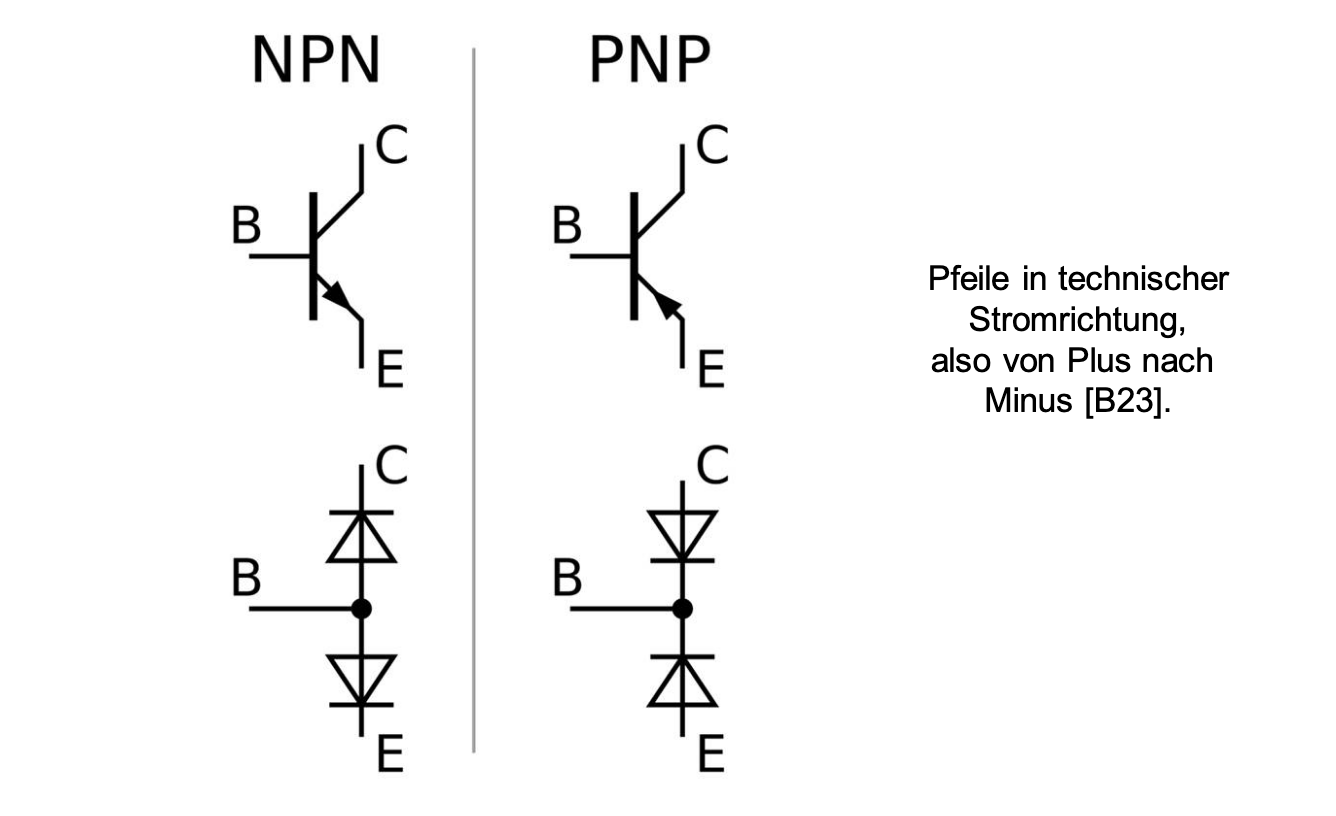

Ein Bipolar-Transistor besteht aus p- und n-dotiertem Halbleitermaterial, entweder als pnp- oder npn-Transistor. Er besteht aus einer Basis, einem Kollektor und einem Emitter. Der Bipolar-Transistor kann in drei Betriebsbereiche aufgeteilt werden: Den Sperrbereich, den Verstärkungsbereich (, ) und einem Sättigungsbereich.

Schaltzeichen und Ersatzschaltbild

Der Bipolar-Transistor als Schalter

Ein Bipolar-Transistor kann als Ein-/Aus-Schalter verwendet werden. Damit der Schalter “Aus” ist, darf kein Basisstrom fließen (). Der Kollektorstrom ist dann (fast) null (). In diesem Zustand sperrt der Transistor den Stromfluss. Dennoch kann er minimale Leckströme haben. Wenn der Schalter “An” ist, fließt ein konstanter Kollektorstrom (). Der Durchgangswiederstand ist konstant und klein, wodurch der Transistor gut leitet und den Stromkreis schließt. Mithilfe des Basisstroms kann der Transistor leitend gemacht werden, solange ein Basisstrom fließt.

⇒ Der Transistor benötigt Zeit, um umzuschalten. Er ist schnell, jedoch nicht unendlich schnell.

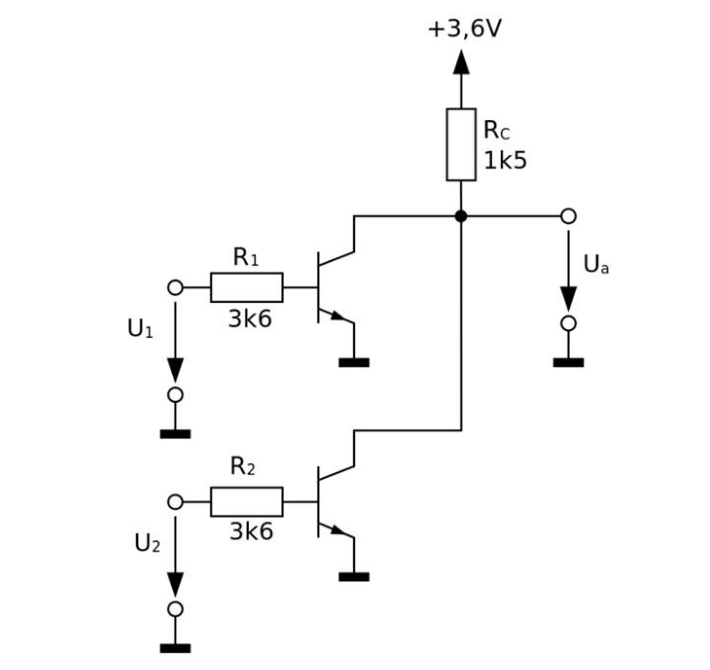

NOR-Gatter aus Transistoren

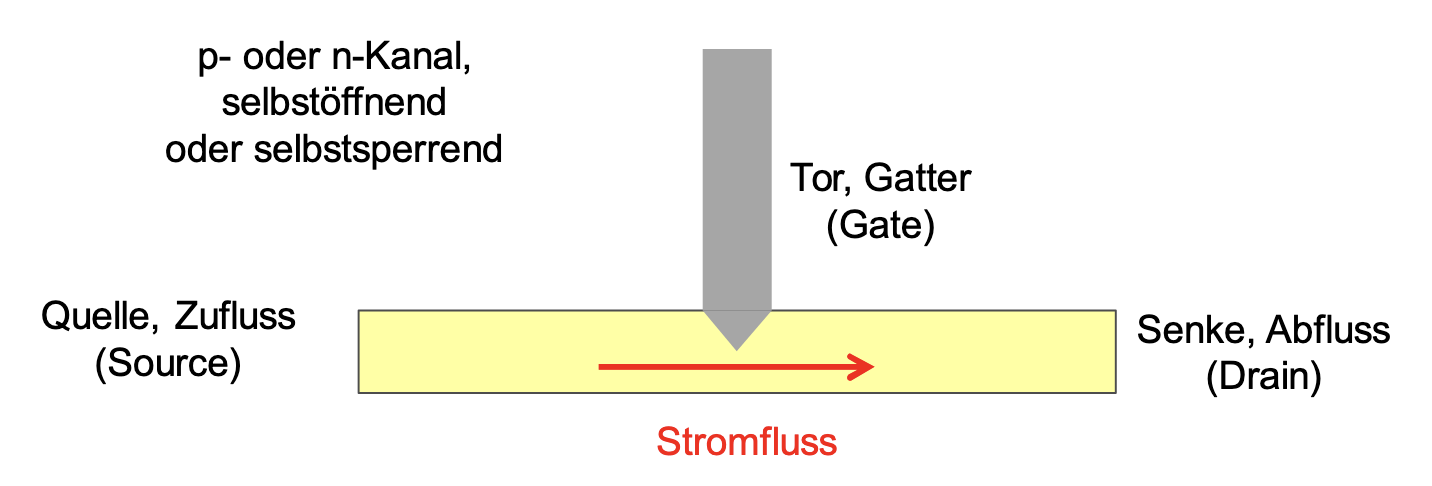

Feldeffekttransistoren (FET)

Ein Feldeffekttransistor schaltet weitgehend leistungs- und verlustlos. Sie werden in Metalloxidhalbleitern (metal oxide semiconductor) verwendet → MOSFET. Auch FETs gibt es in p- und n-leitenden Versionen (P- und NMOS).

MOSFET

Ein MOSFET (Metal-Oxide-Semiconductor Field-Effect Transistor) ist ein spannungsgesteuerter Transistor. Er besteht aus drei Anschlüssen: G: Gate, D: Drain und S: Source. Zwischen Gate und Kanal liegt eine dünne Isolationsschicht, wodurch kein Gate-Strom fließt. Ein MOSFET schaltet, weil eine Gate-Source-Spannung ein elektrisches Feld erzeugt. Dieses Feld bildet oder löscht einen leitenden Kanal zwischen Drain und Source. Dies passiert, wenn eine Spannung an G angelegt wird. Bei einem N-MOSFET fließt kein Strom, solange (der Schwellspannung, 1-4V) ist. Sobald entsteht ein leitender n-Kanal.

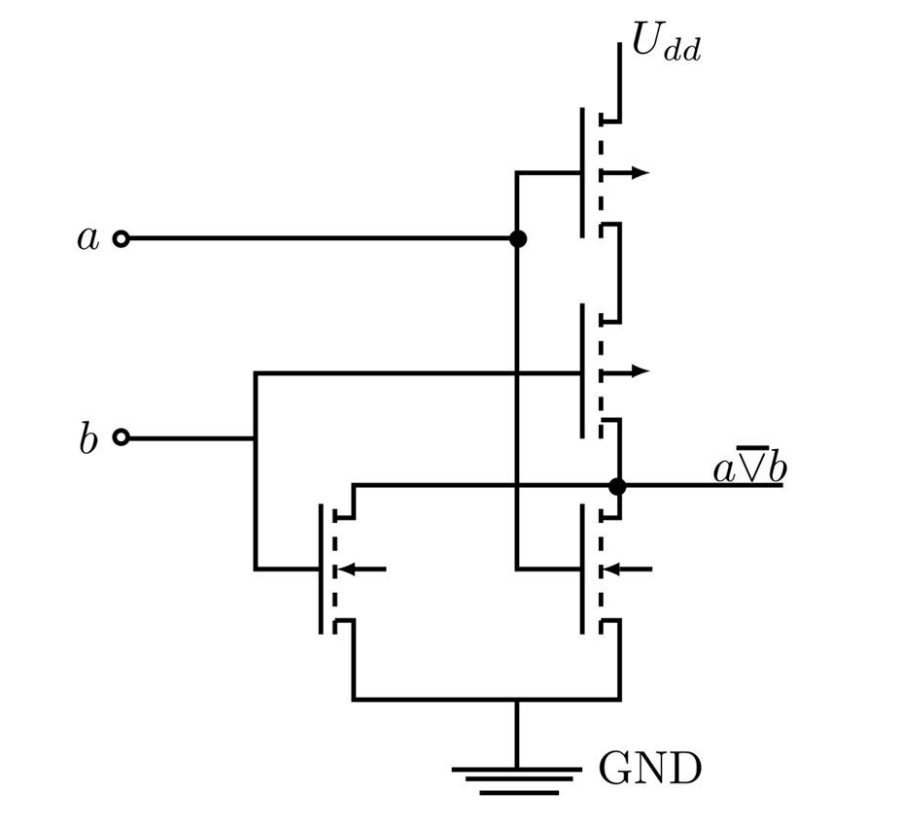

CMOS-Transistoren

CMOSFET (Complementary Metal Oxide Semiconductor Field Effect Transistor) verwenden n- und p-Kanal MOSFETs in Logikschaltungen. Eine CMOS-Schaltung hat eine Verlustleitung von 10nW im Ruhezustand. Die Gatter selber haben eine Verlustleistung von 10µW/MHz.

NOR-Gatter in CMOS

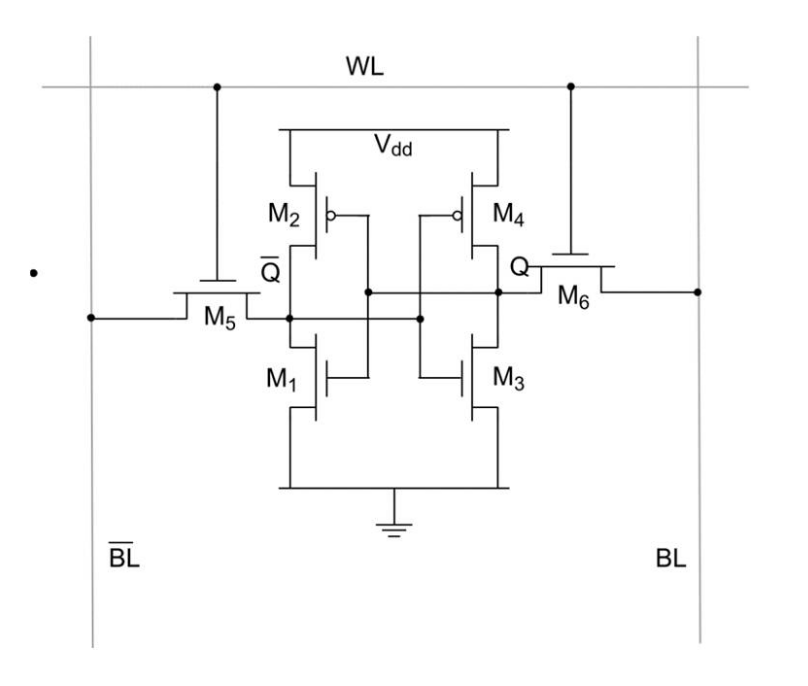

Static Random Access Memory (SRAM)

SRAM Speicher sind Flip-Flop Schaltungen, die in CMOS hergestellt werden. Für eine Speicherzelle werden typischerweise 6 Transistoren benötigt. Speicherzellen sind dadurch recht groß. Heute werden jedoch verhältnismäßig kleine Speicher in SRAM hergestellt. Die Zustände der SRAM-Speicherzellen bleiben ohne Betriebsspannung nicht erhalten. Soll ein SRAM-Speicher also Daten auch im Ruhezustand beibehalten, muss er Batterie-gepuffert sein.

SRAM kann beschrieben werden, indem:

- auf das gewünschte Bit und auf 0 gesetzt wird

- Danach auf 1 gesetzt wird so dass und leiten, wodurch die Flip-Flop-Knoten in den neuen Zustand getrieben werden

Ein Bit kann ausgelesen werden, indem:

- Beide Bit-Lines auf mittlerer Spannung vorgeladen werden ().

- auf 1 gesetzt wird, so dass und leiten

- Der kleine Unterschied auf den beiden Bit-Lines von einem Amplifier erkannt wird

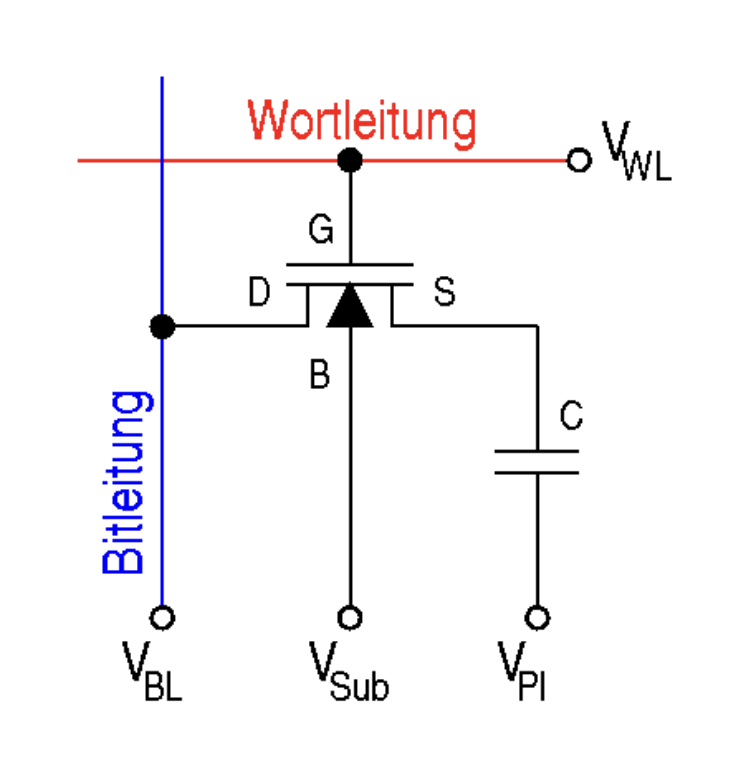

Dynamic Random Access Memory (DRAM)

DRAM ist ein elektronischer Speicher, auf den an beliebigen Stellen zugegriffen werden kann. Eine Speicherzelle besteht dabei aus einem Kondensator und einem MOSFET. Die DRAM-Speicherzellen müssen aufgrund von Leckströmen periodisch aufgefrischt werden, es besteht also Energiebedarf im Ruhezustand eines Rechners. DRAM wird besonders für große Datenmengen bei moderaten Geschwindigkeiten verwendet. Heutige Arbeitsspeichertechnologien basieren auf synchron getaktetem DRAM (SDRAM).

CISC vs. RISC

Heute werden tendenziell beide Architekturen kombiniert: Nach außen werden CISC-Befehle angeboten, intern werden sie in RISC umgesetzt.

CISC

Bei CISC werden komplexe Aktionen in einer einzigen Prozessoranweisung ausgeführt. Alle Anweisungen für den Prozessor sind codiert als sog. Mikrocode und addressieren Mikroprogramme. Durch diesen Ansatz benötigt z.B. ein Assembly-Programm weniger Befehle, allerdings ist die Decodierung des Programms komplex und hat vergleichsweise lange Rechenzeiten.

⇒ Aufgrund der Komplexität gestaltete sich die Weiterentwicklung schwierig.

RISC

Bei RISC sind die Prozessorbefehle einfach gehalten und können innerhalb eines einzelnen Takts ausgeführt werden. Ein Assembly-Programm benötigt zwar mehr Befehle, jedoch ist die Verarbeitung dieser Befehle im Prozessor wesentlich schneller. Außerdem ermöglicht der kleine Befehlssatz Hardware-Optimierungen wie Pipelining.

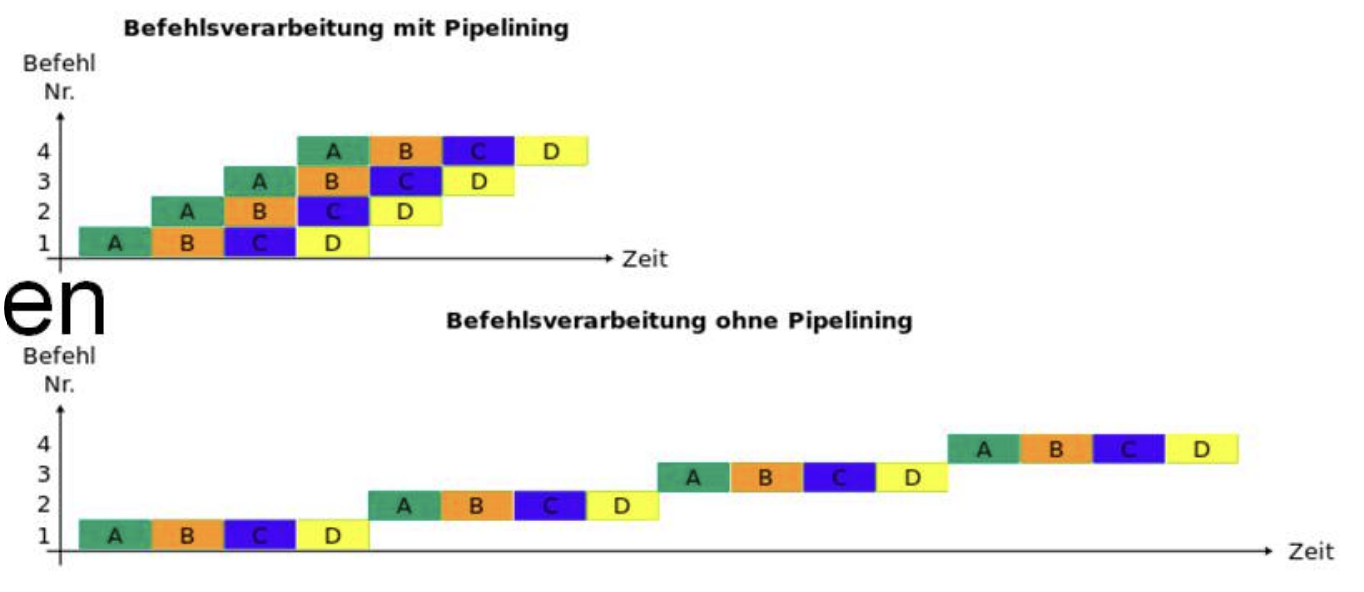

Pipelining

Pipelining ist eine Technik zur Beschleunigung bei der Verarbeitung von Befehlen im Prozessor. Beim Pipelining wird jeder Befehl in Teile zerlegt und “am Fließband” anstatt nacheinander bearbeitet:

- Befehl wird bereit gestellt

- Befehl wird decodiert

- Operanden für ALU werden bereitgestellt

- Operation wird auf ALU ausgeführt

- Ergebnis wird zurückgeschrieben

Dabei könnten jedoch Daten-, Ressourcen- und Steuerflusskonflikte auftreten.

Hindernisse bei der Entwicklung

| Wall | Wann? | Problem | Lösung |

|---|---|---|---|

| Memory Wall | Ende 1980er | Datenrate der Prozessoren wesentlich schneller als die der dynamischen Speicherbausteine → Prozessor zu Schnell | Komplexe Speicherhierarchien, L-Caches |

| Power Wall | Um 2005 | Bis 2005 fand eine stetige Erhöhung der Prozessortaktraten (bis ~3.6GHz) statt. Allerdings führte dies zu wachsender thermischer Belastung. | Taktraten sinken konstakt, Verwendung von extra Transistoren für mehr Kerne |

| Parallelism Wall | Zukunft | Eventuell könnte das Wachstum der Transistoranzahl pro Chip in den nächsten Jahren weiter abnehmen. | Nutzung der Parallelität durch Hyperthreading und eine höhere Anzahl an Kernen, Parallelrechnen als Standardprogrammiermodell |

Halbleiter

Übergang vom Atom zum Festkörper

Wenn zwei Atome sich nahe kommen, können ihre Elektronenhüllen miteinander wechselwirken. In einem Festkörper führt dies dazu, dass die ursprünglich einzelnen Energieniveaus der Atome zu Energiebändern werden. Dabei gibt es typischerweise ein Valenzband, in dem sich die gebundenen Elektronen befinden, und ein Leitungsband, in dem sich Elektronen frei bewegen können. Damit ein Elektron vom Valenzband ins Leitungsband übergehen kann, muss eine bestimmte Energie aufgebracht werden. Diese Energie nennt man Bandlücke (Bandabstand). Wenn die Atome also nah genug beieinander sind und genügend Energie zugeführt wird, kann ein Elektron aus dem Valenzband in das Leitungsband gelangen und sich anschließend durch das Material bewegen. Die Fermi-Energie ist dabei das Energieniveau, das bei tiefen Temperaturen die Grenze zwischen besetzten und unbesetzten Zuständen markiert.

Metall, Halbleiter und Isolator

Die Lage der Energiebänder entscheidet über die elektrische Leitfähigkeit eines Materials. Bei einem Metall überlappen Valenzband und Leitungsband, sodass Elektronen ohne zusätzliche Energie frei beweglich sind. Ein Halbleiter besitzt eine Bandlücke von typischerweise unter etwa 3 Elektronenvolt, sodass Elektronen mit relativ geringer zugeführter Energie vom Valenzband ins Leitungsband gelangen können. Ein Isolator hingegen hat eine Bandlücke von mehr als etwa 3 Elektronenvolt, wodurch ein Übergang ins Leitungsband unter normalen Bedingungen kaum stattfindet. Ein Elektronenvolt (eV) entspricht dabei der Energie, die ein Elektron beim Durchlaufen einer Beschleunigungsspannung von 1 Volt gewinnt. Aufgrund der geringen Bandbreite der Bandlücke wird ein Halbleiter bereits bei Lichteinstrahlung leitfähig!

Manipulation von Halbleitern (Dotierung)

Ein „normaler“ Halbleiter leitet nur bei Energiezufuhr von außen, etwa durch Temperaturerhöhung oder Belichtung. Dies kann durch Dotierung gezielt verändert werden. Beim Dotieren werden Fremdatome eingebracht, die mehr oder weniger Valenzelektronen besitzen als das Halbleitermaterial selbst. Bei Silizium mit vier Valenzelektronen verwendet man typischerweise Bor (mit drei Valenzelektronen → p-Dotierung) oder Phosphor (mit fünf Valenzelektronen → n-Dotierung). Auf etwa bis Siliziumatome kommt ein Fremdatom. Ein dotierter Halbleiter ist wesentlich leitfähiger:

- Beim n-dotierten Silizium gibt das Phosphor ein fünftes Elektron ab, das nahe am Leitungsband liegt und leicht leitend wird.

- Beim p-dotierten Silizium erzeugt das Bor ein Loch (fehlendes Elektron) im Valenzband, das sich wie ein positiver Ladungsträger verhält.

Wenn p- und n-dotierte Bereiche zusammengebracht werden, wandern (diffundieren → zufällige Bewegung vom Bereich hoher Konzentration in den Bereich niedriger Konzentration) die freien Elektronen des n-Gebiets in das p-Gebiet und rekombinieren dort mit Löchern. Gleichzeitig diffundieren Löcher vom p-Gebiet ins n-Gebiet und rekombinieren mit Elektronen. Dadurch entsteht am Übergang eine Verarmungszone, in der kaum freie Ladungsträger vorhanden sind. Aufgrund der getrennten ortsfesten Ionen (positiv im n-Gebiet, negativ im p-Gebiet) baut sich ein inneres elektrisches Feld bzw. eine eingebaute Potentialbarriere auf. Diese verhindert weiteren Ladungstransport im Gleichgewicht. Diese Kombination aus p- und n-dotierten Bereichen nennt man eine pn-Diode. Sie leitet Strom nur in einer bevorzugten Richtung:

- Sperrrichtung: Wird der p-Bereich an den Minuspol und der n-Bereich an den Pluspol gelegt, wird die Verarmungszone größer, die Potentialbarriere steigt, und es fließt praktisch kein Strom. Die Diode sperrt.

- Durchlassrichtung: Wird der p-Bereich an den Pluspol und der n-Bereich an den Minuspol gelegt, wird die Verarmungszone kleiner. Sobald die angelegte Spannung die Potentialbarriere (bei Silizium ca. 0,6–0,7 V) überwindet, können Ladungsträger wieder rekombinieren bzw. nachströmen – die Diode leitet.

Klassische Rechnerarchitekturen

Es gibt zwei Arten von klassischen Rechnerarchitekturen, die jeweils unterschiedliche Vorteile und Nachteile bieten. Heutige Prozessoren mischen beide Architekturen → “best of both worlds”!

von Neumann-Architektur

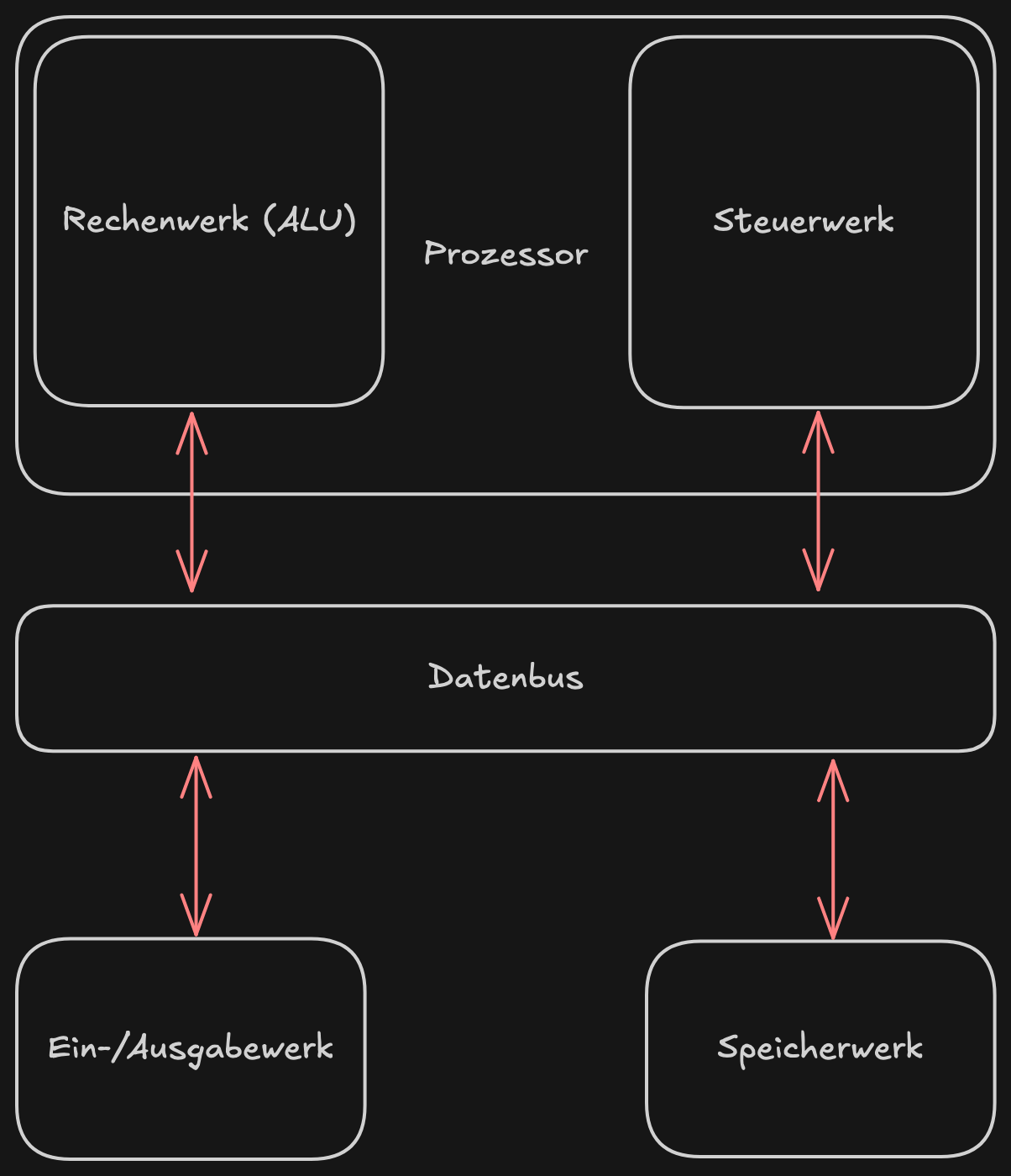

Die von Neumann-Architektur, auch Princeton-Architektur genannt, bildet die technische Grundlage für heutige Rechner. Von Neumann spezifizierte bei dieser Architektur die Komponenten einer universellen, turing-vollständigen Rechenmaschine. Aufgrund der komponentenbasierten Architektur können die Hardware und Algorithmen getrennt werden. Bei vorherigen Modellen benötigte eine Anpassung eines Algorithmus normalerweise eine Änderung der Hardware, doch mit der von Neumann-Architektur wurde es möglich, verschiedene Programme auf der gleichen Maschinen zu rechnen.

Ein Rechner nach der von Neumann-Architektur besteht aus einer ALU (arithmetic logic unit), welche die Rechenoperationen implementiert, einem Steuerwerk, auch Leitwerk genannt, welches den Zugang auf Daten ermöglicht, einem Speicherwerk zum Speichern von Daten und Programmanweisungen und einem Ein-/Ausgabewerk für die Benutzerschnittstelle.

Die von Neumann-Architektur bietet aufgrund des einzigen Datenbus den Vorteil, dass alle Programmabläufe deterministisch sind. Es gibt zudem keine Synchronisationsprobleme, und es werden keine Kohärenzverfahren für konkurrierende Programmanweisungen benötigt.

Allerdings stellt der einzelne Datenbus auch einen Flaschenhals dar. Weil jegliche Kommunikation über den Datenbus erfolgt, wird immer mindestens eine Komponente blockiert. Außerdem finden wir das Problem der Memory Wall hier wieder: da der Speicher außerhalb des Prozessors liegt verlangsamt sich die Zugriffsgeschwindigkeit deutlich.

Schema der von Neumann Architektur

Harvard-Architektur

Alternativ zur von Neumann-Architektur gibt es die Harvard-Architektur. Sie trennt Daten und Programm in zwei verschiedene Adressräume und verwendet dazu zwei Datenbusse. Die Architektur wurde erstmals 1944 im IBM Mark 1 verwendet.

Die Harvard-Architektur lieferte den ersten Ansatz für die Entwicklung von Parallelrechnern. Speicherschutz wurde über die verschiedenen Adressräume garantiert. Die Architektur lies variable Wortbreiten für Daten und Programme zu und war einsetzbar in Microcontrollern und Embedded Systems.

Nachteil der Architektur war, dass freier Programmspeicher nicht zu Datenspeicher umgewidmet werden konnte. Außerdem traten aufgrund der Parallelität Kohärenzprobleme auf, die berücksichtigt werden mussten.

Geräteschnittstellen

Serielle Verbindung

Serielle Verbindungen dienten zur Verbindung zwischen Rechnern oder als Kommunikationsschnittstelle zu einem Rechner. Bei der Verbindung von zwei Rechnern geschah dies durch Modem und Direktverbindung via Telnet, bei Druckern und Mäusen konnten sie zur Eingabe verwendet werden.

RS-232

Die Schnittstelle Radio Sector 232 wurde ursprünglich für die Verbindung zu Modems oder ASCII-Terminals konzipiert.

Leistungsdaten

| Zeichen/Sekunde (Baud) | max. Leitungslänge |

|---|---|

| 2.400 | 900m |

| 4.800 | 300m |

| 9.600 (Fax) | 150m |

| 19.200 | 15m |

| 57.600 (analoges Modem) | 5m |

| 115.200 (Nullmodem) | 2m |

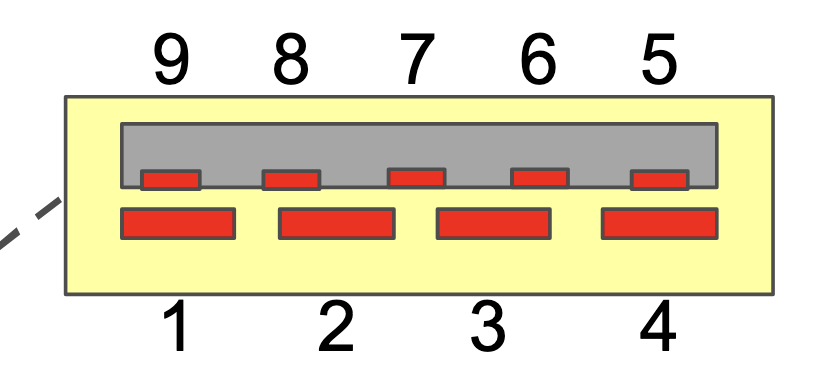

Pins

| Pin | Signal | Kurzbezeichnung | Beschreibung |

|---|---|---|---|

| 1 | DCD | Data Carrier Detect | Modem möchte Daten an den Rechner weitergeben |

| 2 | RD | Receive Data | Dateneingang des Rechners |

| 3 | TD | Transmit Data | Datenausgang des Rechners |

| 4 | DTR | Data Terminal Ready | Rechner ist empfangsbereit |

| 5 | GND | Ground | Nullpotential für alle Signalleitungen |

| 6 | DSR | Data Set Ready | Gerät ist betriebsbereit, aber nicht unbedingt sendebereit |

| 7 | RTS | Request To Send | Rechner möchte Daten senden |

| 8 | CTS | Clear To Send | Modem kann Daten vom Rechner empfangen |

| 9 | RI | Ring Indicator | Rechner wird informiert, dass eine Kommunikation aufgebaut werden soll |

Bei einer Verbindung von Rechner zu modem findet sich am Rechner ein Female-Anschluss, am Modem ein Male-Anschluss.

Universal Serial Bus (USB)

USB ist die heute am weitesten verbreitete Technologie zur Verbindung mit externen Geräten. Die Datenübertragung erfolgt symmetrisch über zwei verdrillte Leitungen D+ und D-. Dieses Prinzip nennt man differenzielle Datenübertragung. Die beiden Datenleitungen transportieren zueinander entgegengesetzte Signale: wenn D+ eine positive Spannung führt, führt D- die gleiche Spannung negativ. Der Empfänger wertet bei Datenempfang die Differenz zwischen D+ und D- aus, nicht den absoluten Wert gegen Masse. Der Vorteil: Die Spannungsdifferenz ist doppelt so groß als bei einer Messung gegen Masse, wodurch das Signal gegen Störungen robuster wird. Sinn der Verdrillung ist, dass äußere Störungen wie z.B. elektromagnetische Felder die beiden Adern des Kabels gleichermaßen treffen. Auch dies trägt zur störsicheren Datenübertragung bei. Durch den Dipol von D+ und D- Adern entstehen zudem deutlich weniger elektromagnetische Störungen.

Ursprünglich war USB für Tastaturen, Mäuse, Drucker und Scanner gedacht und spezifiziert. Heutzutage vereinigt der Standard hohe Datentransferraten mit einfacher Realisierung. Die aktuelle USB-Spezifikation USB 4 definiert Übertragungsraten bis zu 80 GiB/s.

Auf Seiten der Rechner ist USB ist abwärtskompatibel, da die Belegung der Kontakte von den Vorgängerversionen bei USB 3.x abweicht. Stecker auf Geräteseite können auch ggfs. die Version des USB-Protokolls. USB 2.x und 3.x sind dadurch inkompatibel. Auch das USB-Protokoll ist abwärtskompatibel, so dass Geräte verschiedener Spezifikationen gemeinsam miteinander betrieben werden können.

USB 3.0 Signalleitungen

| Pin | Signal | Beschreibung |

|---|---|---|

| 1 | VBUS | Versorgungsspanung, +5V DC |

| 2 | D- | USB 2.0 Data - (differential) |

| 3 | D+ | USB 2.0 Data + (differential) |

| 4 | GND | Masse (Ground) bzgl. Pin 1 |

| 5 | SSRX- | Super Speed Receiver - (differential) |

| 6 | SSRX+ | Super Speed Receiver + (differential) |

| 7 | GND_DRAIN | Masse (Ground) |

| 8 | SSTX- | Super Speed Transmitter - (differential) |

| 9 | SSTX+ | Super Speed Transmitter + (differential) |

USB-C

USB-C ist eine neue, universelle Schnittstelle zwischen Geräten. Mit USB-C können Daten übertragen werden, Geräte können geladen werden (sowohl aus der Steckdose als auch von Gerät zu Gerät), selbst Audio und Video können übertragen werden. USB-C liefert außerdem auch wesentlich neue Eigenschaften wie eine robustere Steckverbindung, symmetrische Anschlüsse ohne Master-/Slave-Verteilung und eine einzige verbleibende Kabelverbindung. Aufgrund des Designs sind USB-C-Kabel symmetrisch, und ein einziges Kabel ist dazu in der Lage, mehrere Funktionen gleichzeitig zu übernehmen.

USB Power Delivery (USB PD)

Neben Datentransfers können Geräte von einem USB-Kabel auch gleichzeitig mit Spannung bis 20V bei 5A, also 100W versorgt werden. So muss nur noch ein einziges Gerät mit externer Spannung versorgt werden, alle angeschlossenen Geräte können ihren Strom via USB beziehen.

Festplatten

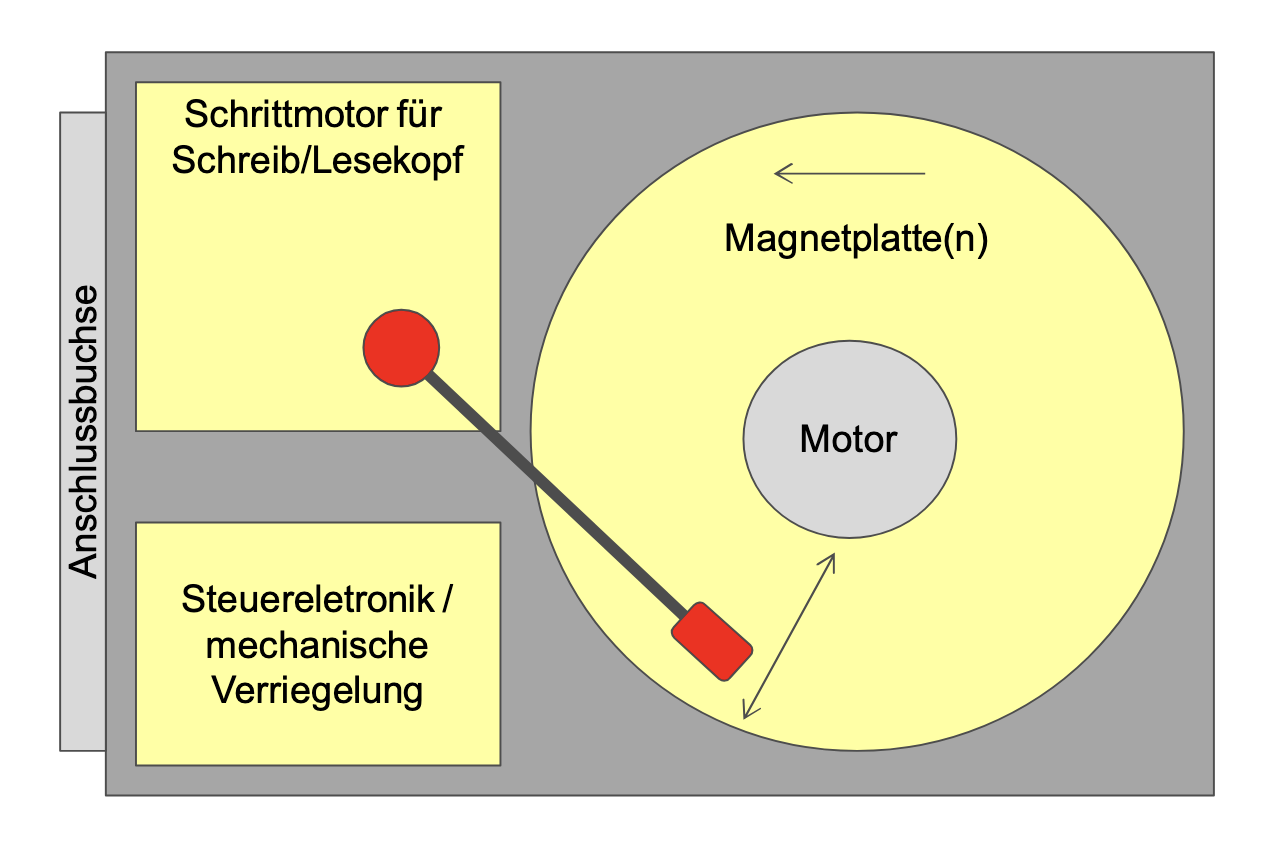

Festplatten sind heute (noch) überwiegend eingesetzte Massenspeicher. Bei mechanischen Festplatten drehen sich ein oder mehrere Magnetscheiben, die von einem Schreib/Lesekopf gelesen bzw. verändert werden. Die Schreib-/Lesegeschwindigkeit von mechanischen Festplatten hängt dabei von verschiedenen Faktoren wie der Drehgeschwindigkeit, lokalen Caches, der Übertragungstechnik zum Rechner und der Platzierung logischer Partitionen des Betriebssystems ab.

Aufbau einer mechanischen Festplatte

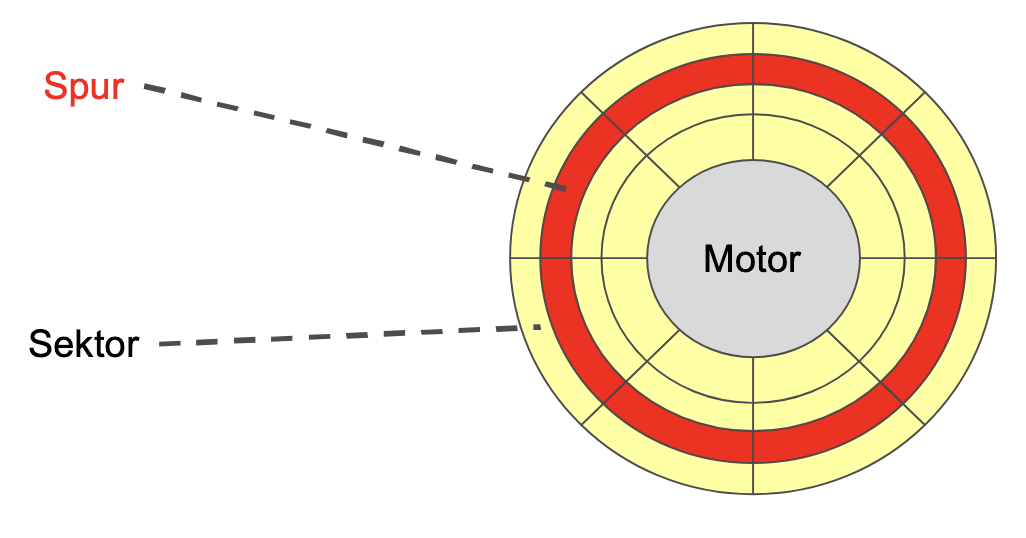

Organisation von Magnetplatten

Festplatten werden in Spuren (cylinder) und Sektoren unterteilt. Die Speicherkapazität lässt sich berechnen aus:

SSD Festplatten

Solid State Disks (SSDs) basieren auf Flash-Speichern und werden mit Caches aus SDRAM (z.B. 1GB) für schnellere Zugriffe ausgestattet. Da SSDs komplett ohne Mechanik funktionieren sind sie optimal für den Einsatz in mobilen Umfeldern geeignet, im Gegensatz zu mechanischen Festplatten, die stoßempfindlich sind.

SSDs werden als NAND-Speicher implementiert, weisen jedoch weniger Schreibzyklen pro Zelle auf und haben damit eine erheblich kürzere Lebenszeit als mechanische Festplatten, die ca. 2000-mal so viele Zyklen durchlaufen können.

RAID

RAID (Redundant Array of Independent Disks) wurde 1987 konzipiert. Die Idee hinter RAID ist, mehrere Festplatten zu einem größeren logischen Laufwerk zu kombinieren, um höhere Ausfallsicherheit und bessere Datenübertragungsraten zu erreichen, die Kosten für größere Platten zu reduzieren und den Austausch von Speichermedien bei einem laufenden System zu ermöglichen. Es gibt verschiedene Level an RAID:

RAID0 “Striping”

Bei RAID0 werden die Datensegmente auf verschiedene Festplatten verteilt, um mehr Speicherplatz auf einer einzelnen “logischen” Festplatte zu erhalten.

RAID1 “Mirroring”

Bei RAID1 werden die Daten einer einzelnen Festplatte auf eine zweite Festplatte repliziert. So kann, sollte die erste Festplatte kaputt gehen, immer noch auf die Daten zugegriffen werden.

RAID5

Bei RAID5 werden mehrere Disks verwendet, um die Daten zu speichern. Ein Datensegment wird dabei auf mindestens drei verschiedene Festplatten verteilt, wobei für jeden Datensatz eine andere Festplatte einen Paritäts-Block enthält. Sollte genau eine der Festplatten ausfallen köpnnen die Daten basierend auf den verteilten Paritäts-Blöcken rekonstruiert werden.